Nous sommes convaincus que des données annotées de qualité sont cruciales pour la réussite des projets d’intelligence artificielle. Une annotation de qualité permet non seulement d’améliorer les performances globales, mais aussi des économies de temps et d’argent.

Pour garantir une qualité irréprochable, chez People for AI, nous travaillons sur les trois axes suivants :

- Formation continue des annotateurs

- Workflows pour évaluer l’exactitude des données annotées

- Processus d’évaluation de la qualité

Formation continue des annotateurs

La formation des annotateurs constitue la base de tout projet d’annotation réussi. Pour que nos annotateurs s’améliorent durant la production, il est nécessaire d’utiliser des process pour encadrer leur processus d’apprentissage. La formation est un processus évolutif et dynamique, loin d’être figé ou monolithique. Nos annotateurs continuent d’apprendre pendant tout le processus de production tout comme ils se forment entre les projets.

Chez People for AI, nous assurons la formation continue de nos équipes grâce à ces cinq piliers.

Former

Avant chaque projet, une formation initiale est dispensée en amont de la phase de production. Elle se base sur les instructions d’annotation fournies par le client, auxquelles les annotateurs peuvent se référer à tout moment. La durée de cette formation dépend de la complexité des tâches à accomplir.

Poser des questions

À chaque projet, nous encourageons nos annotateurs à soumettre des questions par l’intermédiaire d’un fichier de questions-réponses ad hoc. Ces questions suivent ensuite un itinéraire bien défini, elles sont d’abord traitées par les annotateurs seniors, puis par les managers et, si nécessaire, par le client, dans les cas où les réponses internes ne sont pas disponibles. Cette approche par paliers résout les ambiguïtés et les nuances spécifiques qui n’avaient pas été documentés dans les instructions d’annotation. En conservant un fichier Q&A actualisé, nous pouvons avoir une vue d’ensemble de toutes les questions et réponses. Il est ainsi plus facile de clarifier les consignes relatives à l’annotation des données. En rationalisant ce processus, nous nous assurons que la formation et la mise à l’échelle futures seront plus efficaces.

Interagir avec le client

Un moyen efficace pour nos équipes de progresser rapidement est la mise en place de RDVs réguliers entre nos chefs de projet locaux et le client (par exemple, une réunion hebdomadaire peut être programmée). Les explications en direct économisent du temps pour les annotateurs et les clients, surtout dans les cas de projets complexes. En outre, cette approche interactive favorise un sentiment de connexion. Elle permet aux deux parties de rencontrer régulièrement les personnes avec lesquelles elles collaborent, ce qui aide à la motivation des annotateurs.

Interagir avec les autres membres de l’équipe

Du fait que les membres de nos équipes partagent le même espace de travail, ils ont la possibilité de collaborer étroitement et de se soutenir mutuellement sous la direction bienveillante de nos responsables d’équipe. Les responsables d’équipe fournissent également un feedback basé sur les workflows de validation (la review par exemple) et sur les KPIs de qualité mesurés.

Maintenir des équipes stables

Bénéficier d’équipes stables est un avantage, car cela permet de conserver les connaissances au sein de l’entreprise et de minimiser le besoin de re-former de nouvelles personnes. En offrant de bonnes conditions de travail, des avantages sociaux (santé, retraite, formation, etc.) nous favorisons une atmosphère saine au sein de nos bureaux. En conséquence, notre taux de rotation (turnover rate) est remarquablement bas, ce qui, en fin de compte, s’avère profitable pour tout le monde.

« PFAI est un partenaire compétent pour les services d’annotation et nous a soutenus dans plusieurs projets de nature différente. Leurs processus sont très agiles et flexibles, et l’équipe de projet maintient toujours une communication rapprochée avec nous. L’équipe fournit des annotations de haute qualité et cohérentes, mêmes pour des tâches complexes et a prouvé qu’elle disposait des processus à toute épreuve lorsqu’il s’agit des questions-réponses et de la révision des données annotées.«

Sid Hinrichs, responsable de la stratégie chez Pointly

Workflows pour évaluer l’exactitude des données annotées

Un deuxième niveau dans le maintien d’une annotation de données de haute qualité est la sélection d’un workflow, ou processus de validation, approprié pour évaluer l’exactitude des données annotées. Ces workflows sont établis au cours des phases initiales du projet et est fonction de la complexité de la tâche. Les clients ont la possibilité de choisir parmi différents workflows, en décidant s’ils doivent être appliqués à des échantillons ou à l’ensemble des données à annoter.

Quatre workflows principaux peuvent être utilisés pour évaluer l’exactitude des données annotées.

- Sans validation

- Review

- Annotation par consensus

- Honeypot (ou ground truth)

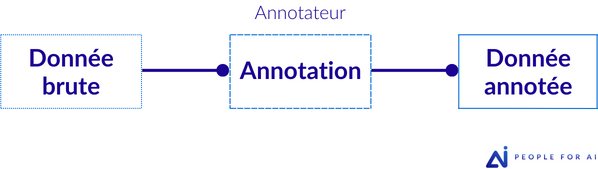

Sans validation

Dans cette approche, il n’y a pas de validation supplémentaire après le travail de l’annotateur. Ainsi, chaque donnée est annotée par un seul annotateur compétent.

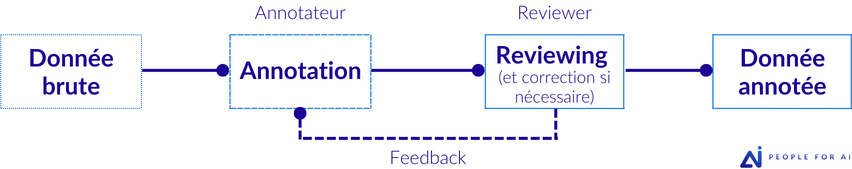

Review

Ce workflow est généralement choisi pour son rapport coût-efficacité. Après l’annotation initiale, une phase de révision et de correction (review) a lieu, fournissant un retour d’information précieux. Dans ce cas, chaque donnée est annotée par un seul annotateur et un reviewer examine tout ou partie de l’ensemble de données préalablement annoté.

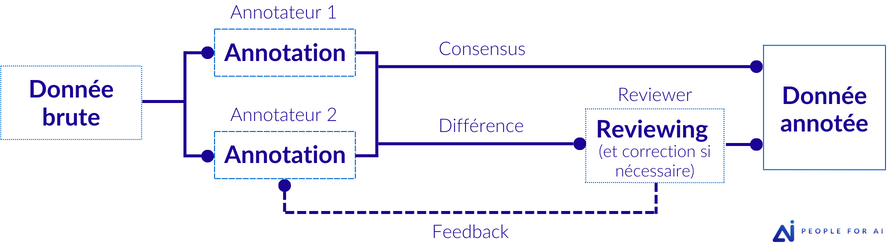

Annotation par consensus

Il s’agit d’annoter plusieurs fois la même donnée. Les données ne sont validées que si tous les annotateurs sont d’accord. Dans ce cas, chaque donnée est annotée par au moins deux annotateurs. Il y a une possibilité de révision (review) en cas de désaccord.

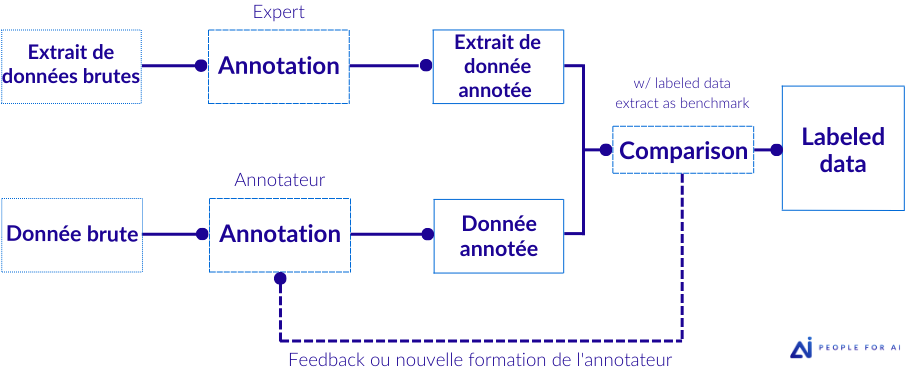

Honeypot (ou ground truth)

Au début du projet, un expert (souvent le client) annote avec précision un sous-ensemble de données. Ce sous-ensemble, appelé « pot de miel » ou honeypot, est ensuite utilisé comme référence (ground truth) pour évaluer la qualité des annotations fournies ultérieurement par les annotateurs. Dans ce cas, chaque donnée est annotée par un seul annotateur. Un expert fournit des références en début de projet.

Il convient de noter que le workflow ne doit pas nécessairement rester statique pendant toute la durée du projet. Pour les projets impliquant la review, une approche impliquant une révision à 100 % serait coûteuse et inefficace. En place de cela, un workflow adaptatif permettrait un meilleur usage de la ressource. On peut par exemple appliquer un processus de révision solide dès le début du projet. Puis, au fur et à mesure que les annotateurs améliorent leurs performances, réduire ce taux de review. Ainsi, un taux de review intelligent ne serait pas constant, il diminuerait progressivement. Le même principe s’applique au vote par consensus, il n’est généralement pas appliqué à l’ensemble du set de données, mais plutôt à une simple fraction de ce set de données, par exemple 10%.

L’agilité joue alors un rôle crucial dans ce processus, en permettant des ajustements et des perfectionnements réactifs, qui auront une incidence favorable sur le coût, la vitesse et la qualité de la production labellisée.

Processus d’évaluation de la qualité

Comme souligné précédemment, la qualité des annotations est essentielle dans les projets d’annotation des données. Toutefois, évaluer cette qualité peut s’avérer coûteux en termes de ressources, autant pour les clients que pour les équipes d’annotation. Dans bon nombre de projets, on tend à privilégier des méthodes et des KPIs de qualité simples, en raison de la facilité de leur mise en œuvre et de la rapidité de calcul.

Bien que de simples KPIs puissent être adaptés à certains contextes, ils ne répondent pas toujours aux exigences des projets les plus complexes. Par conséquent, il est essentiel de trouver un juste équilibre entre efficacité et évaluation précise de la qualité pour optimiser le processus d’annotation des données.

Dans cette optique, examinons trois approches pour évaluer la qualité.

ÉVALUATION SUBJECTIVE

Une des approches les plus communes est l’évaluation subjective. Dans cette démarche, les clients et/ou les experts évaluent (review) les données annotées et jugent sans calcul formel si elles semblent satisfaisantes.

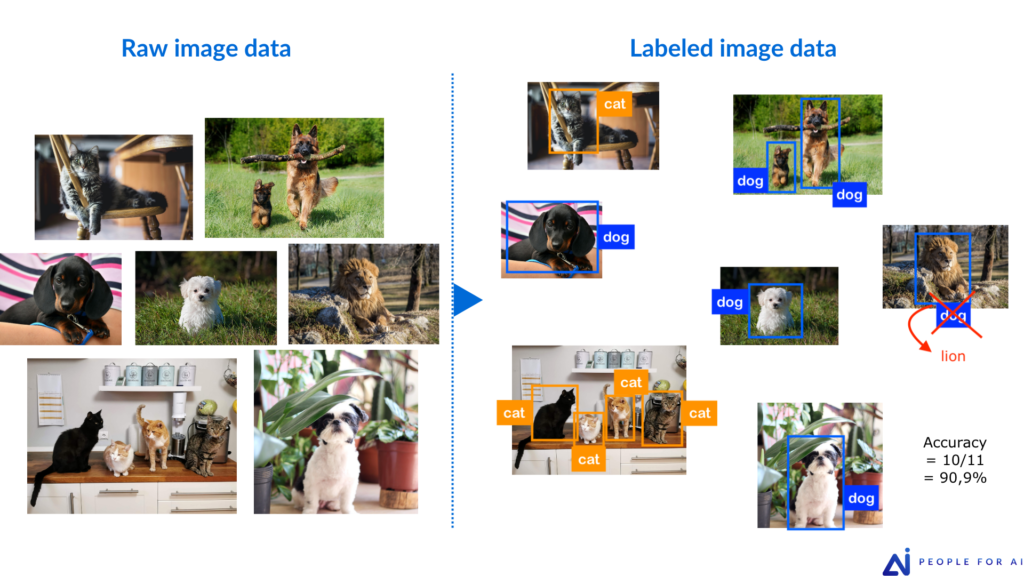

EXACTITUDE (JUSTESSE)

Un autre indicateur simple est l’exactitude, qui mesure le rapport entre les données correctement annotées et le nombre total d’annotations. Il s’agit essentiellement de compter le nombre de points de données bien annotés sur le total observé, puis de calculer le pourcentage de données bien annotées. L’exactitude peut être calculée par annotation ou par image/vidéo/document/fichier.

L’exactitude concerne la justesse ou la fiabilité des annotations. Elle se concentre sur la réduction des faux positifs et des faux négatifs, ce qui englobe les erreurs de présence/absence (par exemple, la présence/absence d’une Bbox ou d’une segmentation) et de classification (par exemple, l’identification correcte de l’objet).

L’exactitude est une mesure courante dans le processus d’évaluation de la qualité, où le pourcentage d’annotations considérées comme exactes est évalué par le client, un expert ou des annotateurs seniors. Par exemple, si un échantillon de données est examiné et que 96 % des annotations sont jugées correctes, nous pouvons conclure que les données échantillonnées ont atteint une exactitude de 96 %.

Toutefois, il faut tenir compte du fait que ce processus d’évaluation entraînera des efforts supplémentaires. Les clients devront vérifier par eux-mêmes ou annoter certains échantillons de données à des fins d’évaluation.

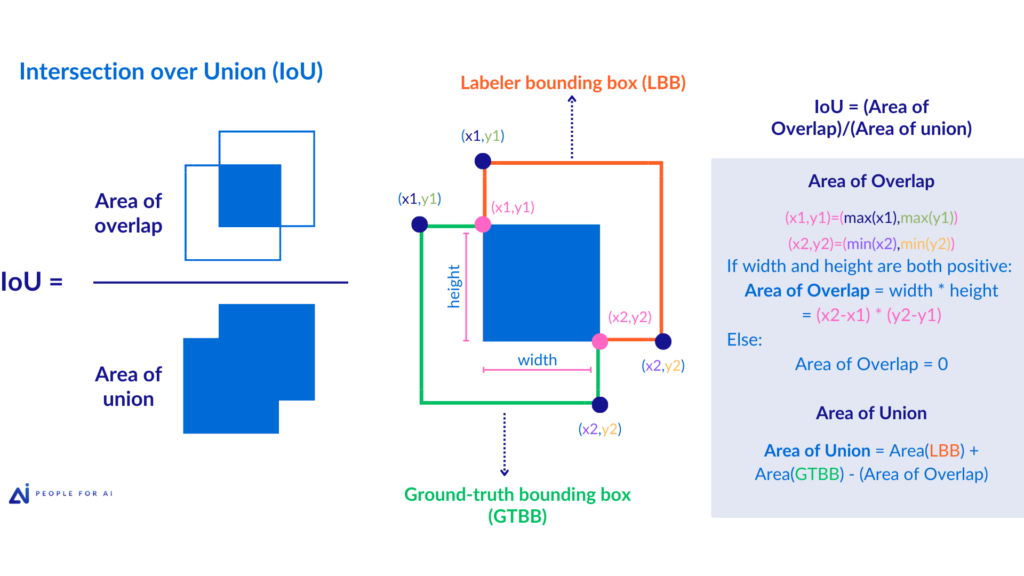

PRÉCISION GÉOMÉTRIQUE

La précision géométrique est une autre mesure intéressante, même si elle est souvent plus gourmande en ressources. Elle fait référence au niveau d’exactitude géométrique ou de détail requis dans les annotations.

Une grande précision géométrique exige des annotations plus détaillées et méticuleuses, ce qui peut augmenter le temps passé par annotation. Il s’agit souvent de mesures telles que la précision avec laquelle une Bounding Box doit entourer les côtés d’un objet ou la précision avec laquelle des points clés doivent être placés dans une image.

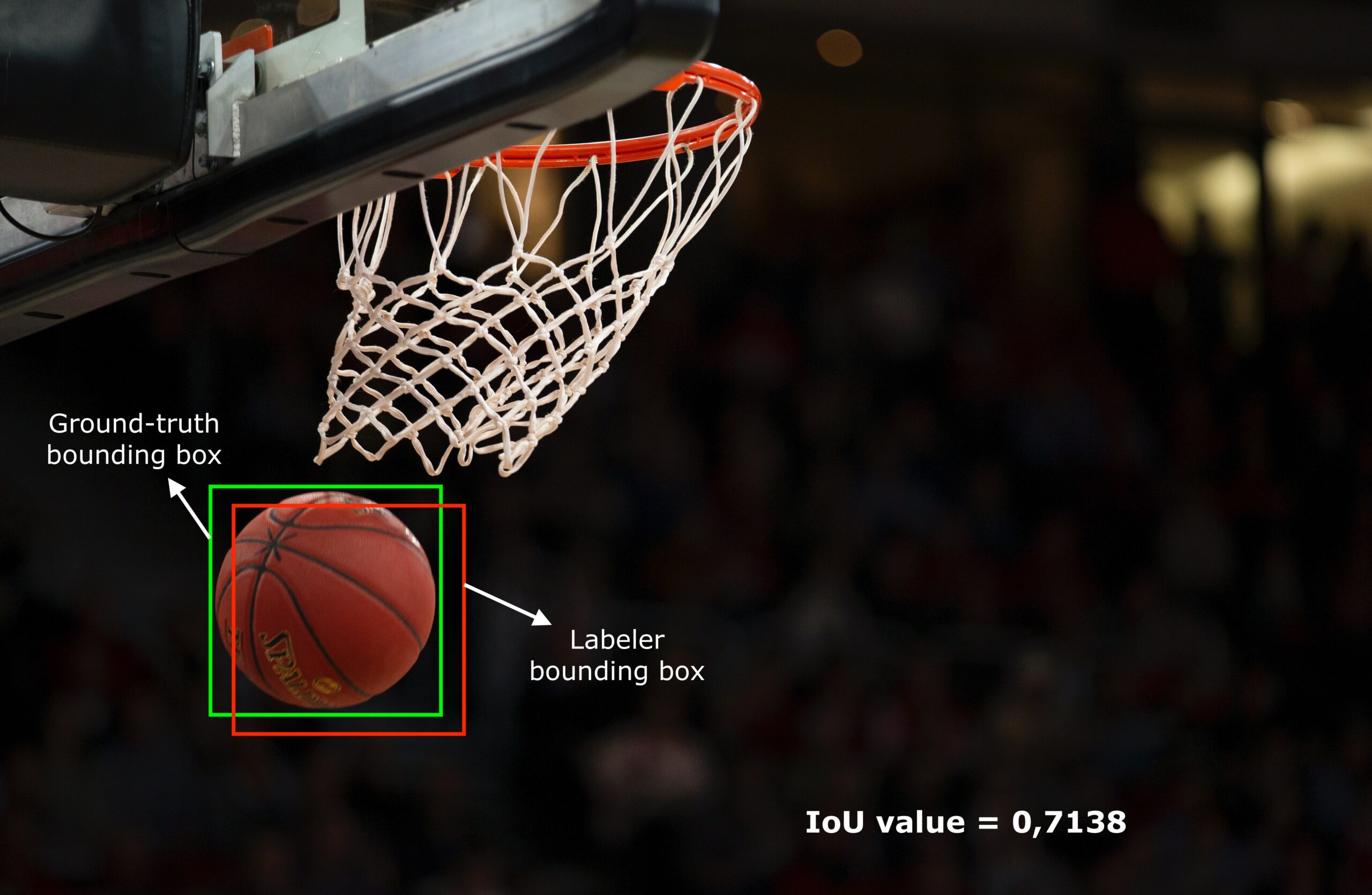

Un exemple de mesure de précision est l’Intersection sur l’Union (IoU), qui peut être utilisée pour les annotations de la Bounding Box. La valeur IoU est utilisée pour mesurer la précision de la Bounding Box autour d’un objet sans être trop restrictive. Tout d’abord, un expert doit annoter un extrait de données qui fera office de référence. C’est-à-dire, ses Bounding Boxes seront considérées comme ayant une précision de 100 %. Puis, en calculant l’IoU, il évaluera à quel point les Bounding Boxes des autres annotateurs s’alignent sur cette référence.

Le rôle du client

Si les workflows de validation et l’apprentissage continu sont importants, ils ne peuvent être contrôlés que grâce à des indicateurs clés de qualité (KPIs). C’est le client, conjointement avec l’entreprise d’annotation, qui détermine, en fonction des besoins spécifiques du projet, les KPIs et leurs seuils de validation. Ces derniers permettant de contrôler et de garantir la qualité des annotations. Ainsi, les contributions et les exigences du client sont d’une importance capitale dans la définition de ces critères.

L’implication du client dès le début du projet est essentielle. Elle garantit l’alignement sur les objectifs de qualité, favorisant une approche collaborative pour l’annotation des données.

Cela a été particulièrement le cas lors du projet Foodvisor, où la complexité du projet (6 classes de géométries différentes et +1500 classes d’aliments répertoriées) ont nécessité l’utilisation de métriques complexes. L’utilisation de nombreux KPIs a complexifié le suivi de la qualité en début de projet. Cependant, au fur et à mesure que la qualité des annotations s’améliorait et que les annotateurs gagnaient en compétence, nous avons constaté que des mesures plus simples suffisaient, ce qui a conduit à l’abandon de nombreux KPIs.

Le rôle du People for AI

Notez que, pour faciliter l’atteinte des KPIs de qualité, les annotateurs doivent faire partie d’une équipe soudée. Ensemble, les membres de cette équipe et leurs managers peuvent assurer une gestion constante des objectifs fixés par le client. En outre, selon les besoins du projet, le suivi des KPIs de qualité devra être fait fréquemment, ce qui nous permet d’anticiper de manière proactive les problèmes potentiels et de fournir un feedback opportun à nos annotateurs. Cette rétroactivité favorise un cycle d’amélioration continue, permettant aux annotateurs d’affiner leurs compétences et de fournir des annotations plus précises.

Conclusion

En mettant en œuvre trois approches clés – la formation continue des annotateurs, les workflows d’évaluation de l’exactitude et les processus d’assurance qualité – People for AI vise à optimiser la qualité des annotations. Notre objectif est de contribuer au succès des projets d’IA tout en optimisant l’efficacité et en maîtrisant les coûts. Pour autant, il est important de souligner que la qualité ne repose pas uniquement sur les mesures décrites précédemment. Elle doit être le fruit d’une collaboration étroite et transversale au sein de toute l’organisation. Encourager les annotateurs à poser des questions, conserver les annotateurs les plus compétents grâce à une atmosphère de travail et une rémunération compétitive, et manager la connaissance au sein de notre organisation sont d’autres aspects cruciaux qui renforcent notre engagement à fournir aux clients une qualité d’annotation de données exceptionnelle.